Pyo_trek

Posiadacz elektryka

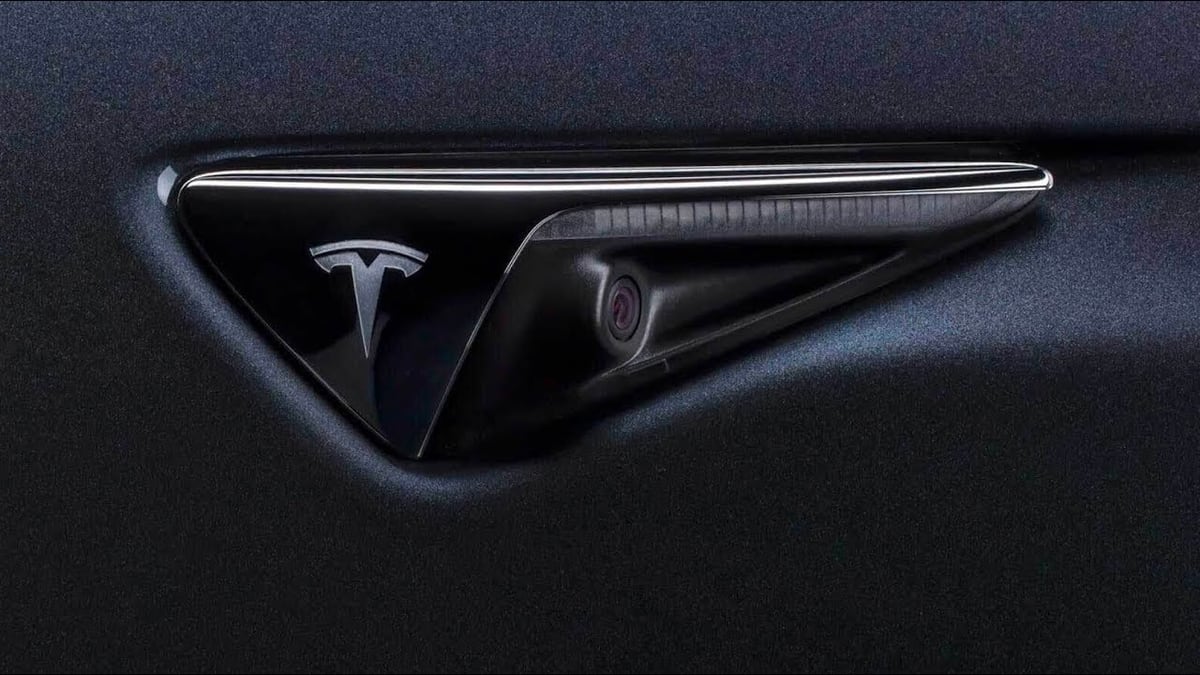

Tesla FSD hardware 4.0 cameras are now being shipped according to supplier

Not much has been revealed about Tesla's next-generation self-driving computer, hardware 4.0. It has yet to be confirmed but recent news out of China suggests t